近年、ChatGPTなどで注目されている生成AIは、クリエイティブ分野やデータ解析分野などでさまざまなビジネスチャンスを創出する可能性を持つ技術です。しかし、そうしたメリットがある一方で、生成AIのビジネス活用にはいくつかの重要なリスクも存在します。

本記事では、企業が生成AIを活用したいときに知っておくべきリスクの種類と、企業が行うべきリスク管理について解説します。

生成AIは、ディープラーニングの手法により新しいデータを生成する技術

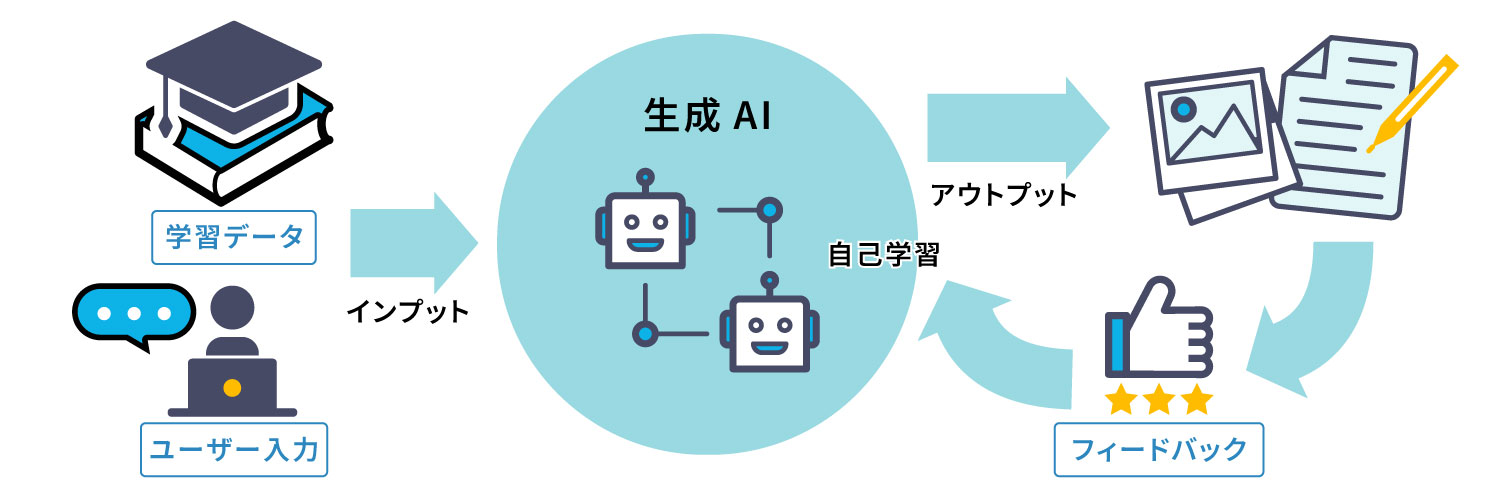

生成AI(Generative AI:ジェネレーティブAI)とは、ディープラーニング(深層学習)と呼ばれる機械学習の手法を用いて、コンテンツなどの生成を可能にする技術です。

従来のAIとは異なり、専門知識がなくても簡単に操作できることが特徴で、プロンプトと呼ばれるテキストを入力するだけで、テキスト生成、画像生成、動画生成、音声生成などを行うことができます。

生成AIのベースとなっているディープラーニングは、ニューラルネットワークと呼ばれる人間の脳の動きを模した手法です。人間の脳と同じように、大量のデータを多層的に分析・判断していくことで学習し、入力データにもとづいて新しいデータを生成(アウトプット)することができます。さらに、アウトプットに対するフィードバックによって自己学習を繰り返し、精度を高めていくのです。

この能力は、文章や画像の作成だけでなく、議事録の要約、他言語からの翻訳、データ分析の効率化、予測モデルの構築、チャットボット、プログラミングなどにも活用され、多様なビジネス分野で利用されています。

その一方で、この技術をビジネスに活用する際には、リスクが伴うことにも注意しなければいけません。

生成AIを活用する際のセキュリティ面のリスク

生成AIを活用する際のリスクとは、どのようなものなのでしょうか。まず、セキュリティ面のリスクについて解説します。

機密情報が学習データとして利用されることで漏洩するリスク

生成AIをビジネスに活用する際に注意すべきリスクのひとつが、機密情報の漏洩です。ユーザーが生成AIに生成してもらうための学習データとして個人情報や機密情報などを入力すると、そのデータはAIの学習の対象となりえます。学習データとして取り込まれた情報は、別のアウトプットデータに含まれることも考えられ、意図せず機密情報が公開されてしまうかもしれません。

これを防ぐために、自社専用の環境を構築して機密情報を保護するには、通常かなりのコストがかかります。クラウドサービスを利用する場合でも、適切なセキュリティ対策が必要となり、そのためのリソースや専門知識が求められるのです。

サイバー攻撃により情報が漏洩するリスク

生成AIをビジネスに利用する場合、サイバー攻撃のリスクも考慮しなければなりません。一般的なSaaSを利用するときなどと同様、万一、生成AIサービスを提供する事業者がハッキングされると、生成AIが扱うデータやモデルが漏洩する危険があります。こうしたリスクにきちんと取り組んでいる事業者を見極めることが大切です。

あるいは、企業が自社で生成AIシステムを構築している場合、そのデータやモデルがサイバー攻撃のターゲットとなるリスクがあります。

生成AIを活用する際の法的なリスク

生成AIの利用には、法的なリスクも伴います。特に、知的財産権とプライバシーの侵害については注意が必要です。

知的財産権を侵害するリスク

生成AIが生成したコンテンツをそのまま公開することは、知的財産権の侵害につながるリスクがあります。AIが既存の作品やスタイルを学習し、新しいコンテンツを生成すると、そのコンテンツが既存のクリエイターの作品に類似してしまう可能性があるためです。

具体的には、著作権、著作者人格権、商標権、意匠権といった知的財産権を侵害するおそれがあります。

例えば、AIが生成した文章や画像が既存の著作物と類似している場合、その著作権者から著作権侵害として訴えられるかもしれません。

また、生成AIが商標やロゴを生成し、それが既存の商標と類似していて混同を招くものであれば、商標権侵害となるおそれがあります。

プライバシーを侵害するリスク

生成AIが大規模なデータを扱う際には、特に個人情報を含むデータに関してプライバシー侵害のリスクが懸念されます。生成AIがこういったデータを学習すると、外部へ漏洩するリスクが増加するためです。

例えば、医療分野で活用されている生成AIが患者の健康データを学習している場合、そのデータの利用方法によっては、患者のプライバシーを侵害するおそれがあります。このようなリスクに対処するには、データの匿名化や暗号化といった保護措置を講じるとともに、患者本人にデータの活用に関する明示的な許可を得るべきです。

また、生成AIを活用して行うプロファイリングが問題となるケースも考えられます。生成AIは、個人の行動履歴、購買履歴、ソーシャルメディアでの活動など、さまざまなパーソナルデータを収集して学習し、それをもとに個人の趣味嗜好、行動予測、健康状態、信用力などを推測することが可能です。

こうした生成AIによるプロファイリングも、プライバシーの侵害にあたらないかをよく吟味することが求められます。

特に、収集データに政治的信条や健康状態、あるいはカメラによる画像データといったセンシティブな情報が含まれている場合、情報を収集されること自体に嫌悪感を覚える人もいます。知られたくない情報が他人に取得され利用されることには、多くの人が不安を覚えるでしょう。

加えて、生成AIによるプロファイリングの結果が必ずしも正確であるとは限りません。生成AIを活用しようとする際には、これらのことに十分な配慮が必要です。

生成AIを活用する際の社会的なリスク

社会的なリスクとは、生成AIを使用する側のユーザーや企業だけではなく、生成AIに関わっていない人まで含めた社会全体に与える悪影響を指します。生成AIは、間違った情報や偏った情報をアウトプットする可能性もあることに注意が必要です。

誤情報を拡散させるリスク

生成AIがアウトプットした情報が、すべて正しいという保証はありません。生成AIが学習したデータが不完全であったり、偏りがあったりする場合、生成されたテキストの内容も誤った情報となる可能性があります。このような誤情報がウェブ記事などとして公開されて拡散されると、社会に混乱を招くリスクがあります。

企業や個人が生成AIの情報を利用する際は、その情報の正確性を厳密に確認することが重要です。情報の提供に伴う最終的な責任は、あくまで企業にあることを認識し、生成AIが提供する情報に対して適切なフィルタリングや検証を行うことで、誤情報の拡散を防がなくてはなりません。

また、ディープフェイクなどの新しいAI技術に対する警戒心も必要です。生成AI技術のひとつであるディープフェイクは、既存の映像や音声をもとに、ディープラーニング技術を用いて実際には存在しない偽のコンテンツを生成する技術です。この技術を使うと、極めて高度な映像や音声の編集によって、特定人物の顔を模したリアルな偽造コンテンツなどを作成することができてしまいます。

実際に、政治家が行っていない演説をディープフェイクによって作成した動画がインターネット上で共有され、社会に混乱を招くという事態も起きています。

企業がディープフェイクを利用して偽造コンテンツを作り出すというケースは通常考えられませんが、従業員がディープフェイクにだまされてしまわないよう、危険性を認識しておいてください。

特定の偏見や差別を助長するリスク

生成AIが作り出すコンテンツの内容は、学習するデータに依存します。誤ったデータや偏ったデータを学習すれば、生成されるコンテンツにもバイアスがかかります。このことで、特定の偏見や差別を助長するかもしれません。

これに対処するには、学習データそのものの選定に注意を払い、公正かつバランスのとれたデータのみを使用する環境を整えることが重要です。

また、生成されたコンテンツを定期的にチェックし、バイアスが含まれていないかを確認するプロセスを設けることも有効でしょう。

企業における生成AIのリスク管理

では、ここまで見てきたような生成AIにまつわるリスクに対し、企業はどのような対策を講じるべきなのでしょうか。企業におけるリスク管理について、ポイント別に紹介します。

セキュリティ対策の導入

企業が生成AIを活用する際には、まずセキュリティ対策を徹底することが重要です。セキュアな環境のストレージサービスを利用し、データの安全な保管を確保することが求められます。

また、信頼できる生成AIベンダーを選定し、セキュリティ基準を満たした生成AIサービスを利用することもリスク管理に有効です。強固なセキュリティ対策を構築しているサービスを活用することにより、機密情報の漏洩やサイバー攻撃のリスクを最小限に抑えることができます。

適切なデータ使用の徹底

生成AIが使用するデータに関しては、データ提供元からの明確な許可を取得することが不可欠です。違法に取得されたデータや許可のないデータの使用は、法的リスクを発生させる危険性があります。

さらに、コンテンツが生成AIによるものであることを明示することも重要です。クレジットなどで利用者にわかりやすく示すことで透明性を保てば、不信感を持たれたり誤解されたりしにくいでしょう。

このように、適切にデータを使用するという意識を徹底することも、リスク管理といえます。

プライバシーの保護

プライバシーの保護は、生成AIの利用において極めて重要なポイントです。特に個人情報を扱う場合は、十分な配慮が必要です。

プライバシーの保護を実施するには、個人データを匿名化するほか、個人情報の削除リクエストに迅速に対応できるシステムを構築する必要があります。

また、従業員や利用者に対してプライバシー保護の重要性を周知し、個人情報の適切な取り扱いに関する教育を行うことも重要です。

なお、海外で事業を展開している場合には、現地の規制にも配慮する必要があります。例としては、EU域内で個人データを処理する企業に適用されるGDPR(General Data Protection Regulation:一般データ保護規則)、アメリカのカリフォルニア州に拠点を置く企業や同州に関連するビジネスを展開する企業に適用されるCCPA(California Consumer Privacy Act:カリフォルニア州消費者プライバシー法)といったものです。

生成AIのビジネス活用は、リスク管理とセットで検討しよう

生成AIのビジネス活用には多くのメリットがある一方で、さまざまなリスクも伴います。セキュリティリスクや法的リスク、社会的な影響、プライバシーの侵害といった問題が存在し、企業はそれらのリスク管理に注力することが不可欠です。生成AIのビジネス活用とリスク管理は、常にセットで考えるべきだといえます。

ソフトクリエイトが提供する Safe AI Gateway は、企業が生成AIを安全・簡単に利用できるように開発されたサービスです。企業内に ChatGPT を用いた安全な専用環境を作ることで、セキュアな生成AI活用を実現します。また、生成AI型のチャットボットを自社で簡単に作ることも可能です。

Safe AI Gateway をご検討中の企業様は、まずは無料トライアルで導入前の不安を解消してはいかがでしょうか。無料トライアルは、下記のリンクよりお申込みください。